I find this shocking:

-

I find this shocking:

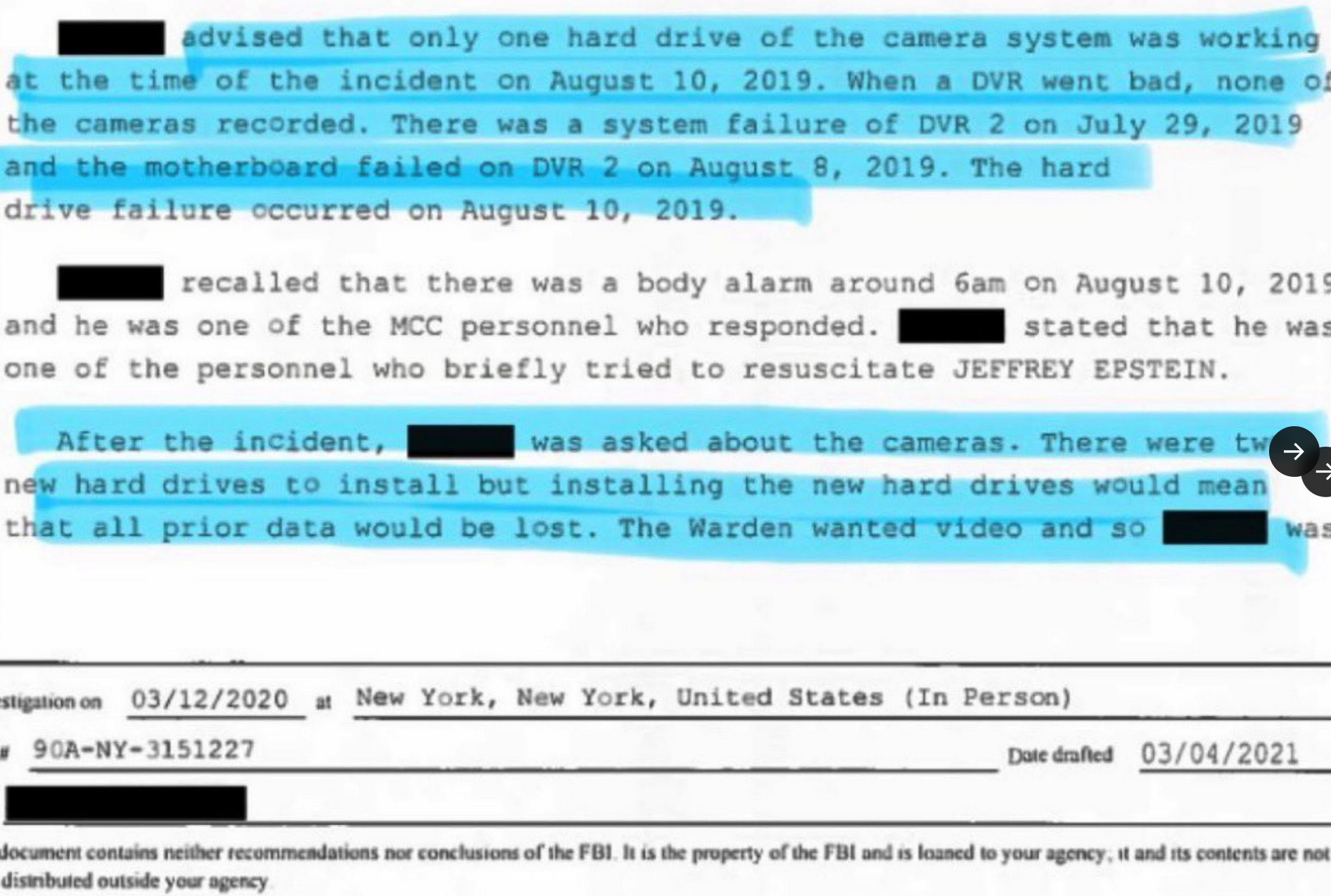

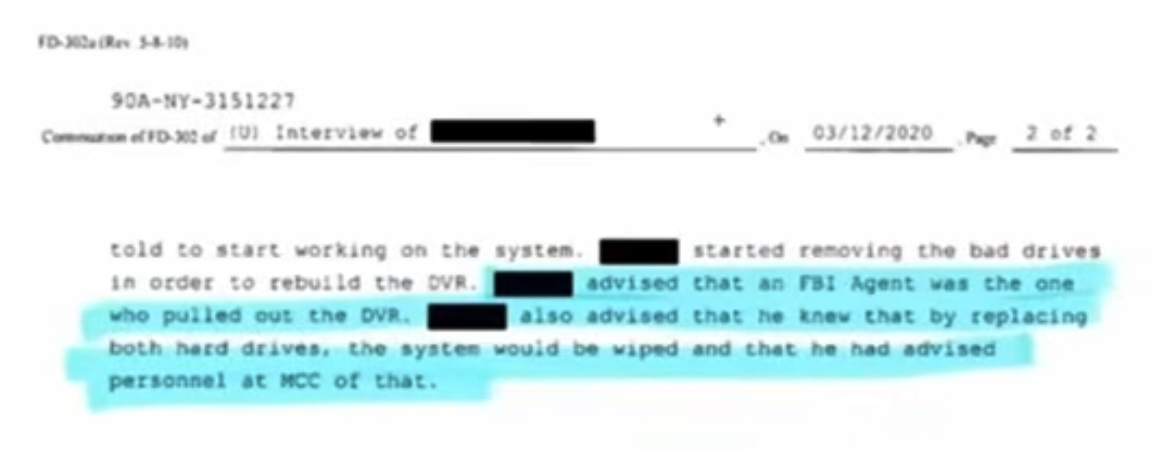

In the recent file release we have new documents that show that the prison footage of Epstein's cell was deleted by an FBI agent who was advised (or someone was advised) that this action would delete the footage.

...

OK. Sure. Great. Wonderful. Makes total sense.

This has not gotten much traction and it's making me feel a little like a crazy person.

Is anyone going to ask why the FBI deleted this footage?

Did you see this ?

Wherein people found that by changing the extensions of released files unreleased information could be found?

Particularly some of the links in the now heavily censored reddit thread which are to footage in the prison from which only screenshots were officially released.

-

I find this shocking:

In the recent file release we have new documents that show that the prison footage of Epstein's cell was deleted by an FBI agent who was advised (or someone was advised) that this action would delete the footage.

...

OK. Sure. Great. Wonderful. Makes total sense.

This has not gotten much traction and it's making me feel a little like a crazy person.

Is anyone going to ask why the FBI deleted this footage?

The FBI routinely conspires to protect powerful people. That's what it's for.

This doesn't get much traction because everyone already knows that the FBI does this. Look at pretty much any previous FBI case connected to politics.

-

The FBI routinely conspires to protect powerful people. That's what it's for.

This doesn't get much traction because everyone already knows that the FBI does this. Look at pretty much any previous FBI case connected to politics.

"This doesn't get much traction because everyone already knows that the FBI does this."

Rich you know this. I know this, but I don't think "everyone" knows this nor do I think it's not what your typical person would find... boring. No. Not at all.

-

"This doesn't get much traction because everyone already knows that the FBI does this."

Rich you know this. I know this, but I don't think "everyone" knows this nor do I think it's not what your typical person would find... boring. No. Not at all.

@futurebird

The one uniting principle amongst Americans is being anti-corruption. This is so corrupt, it stinks to high heaven!

@richpuchalsky -

Did you see this ?

Wherein people found that by changing the extensions of released files unreleased information could be found?

Particularly some of the links in the now heavily censored reddit thread which are to footage in the prison from which only screenshots were officially released.

I find the theory that Epstein is still alive deeply annoying and I kind of struggle to explain why?

Maybe it's because it makes *me* feel silly:I want to think that *my* skepticism is... mostly reasonable. Informed even? IDK.

But also, I just don't think it would happen. He was a very useful and connected person, but no one cared enough to go through all the work and danger of "getting him out" Why?

Even Epstein was disposable to these people.

-

Did you see this ?

Wherein people found that by changing the extensions of released files unreleased information could be found?

Particularly some of the links in the now heavily censored reddit thread which are to footage in the prison from which only screenshots were officially released.

That said this that thing they have blocking the view is... it's just another odd thing that I do not like. The stuff this guy found is interesting.

-

He’s been going on shows and showing autopsy photos of his brother that don’t add up to the official story and making a fuss about it when he (as the only person who knows where his brother is buried) could have the body exhumed and re-examined at any time.

-

I find the theory that Epstein is still alive deeply annoying and I kind of struggle to explain why?

Maybe it's because it makes *me* feel silly:I want to think that *my* skepticism is... mostly reasonable. Informed even? IDK.

But also, I just don't think it would happen. He was a very useful and connected person, but no one cared enough to go through all the work and danger of "getting him out" Why?

Even Epstein was disposable to these people.

Agreed, I see no evidence for the still alive thing, but there is at least circumstantial evidence for the murder hypothesis.

-

Agreed, I see no evidence for the still alive thing, but there is at least circumstantial evidence for the murder hypothesis.

My annoyance with it goes deeper than the lack of evidence. Normally when you have a company or the government acting shady like this. I'm rather patient with the theories that grow to fill the gap. They earned it.

But the idea that's "Epstein is alive" is just so detached from how any of this could possibly work ... it's TV series thinking.

*Who* would want to keep him alive? Isn't the whole point that there were so many who wanted him gone?

-

My annoyance with it goes deeper than the lack of evidence. Normally when you have a company or the government acting shady like this. I'm rather patient with the theories that grow to fill the gap. They earned it.

But the idea that's "Epstein is alive" is just so detached from how any of this could possibly work ... it's TV series thinking.

*Who* would want to keep him alive? Isn't the whole point that there were so many who wanted him gone?

Which begs the question of who may wish to promote irrational hypotheses. It's Q-Anon territory. Distraction.

-

I find the theory that Epstein is still alive deeply annoying and I kind of struggle to explain why?

Maybe it's because it makes *me* feel silly:I want to think that *my* skepticism is... mostly reasonable. Informed even? IDK.

But also, I just don't think it would happen. He was a very useful and connected person, but no one cared enough to go through all the work and danger of "getting him out" Why?

Even Epstein was disposable to these people.

@futurebird They're all disposable to each other, all in a giant game of insecurity and status that drives them insane. None of them can sit quietly, by themselves, thinking, and just be ok, much less happy.

-

He’s been going on shows and showing autopsy photos of his brother that don’t add up to the official story and making a fuss about it when he (as the only person who knows where his brother is buried) could have the body exhumed and re-examined at any time.

I thought you were implying that he doesn't want to investigate further. Has he said he's opposed to doing it?

I would imagine he might have some mixed feelings about the guy. He might also be scared of the people who could have killed him?

Exhuming is expensive. Who would pay for it? He has a medical examiner but unless he plans on suing the government what is the point?

-

Which begs the question of who may wish to promote irrational hypotheses. It's Q-Anon territory. Distraction.

I kind of wonder if the "he lives" story is out there to make the much less wild

"maybe they just let him kill himself because it solved some problems" theory

and the

"someone killed him" theory

seem less credible.

I consider both very reasonable. Impossible to rule out. Silly not to consider.

-

Which begs the question of who may wish to promote irrational hypotheses. It's Q-Anon territory. Distraction.

@zl2tod @futurebird

Distraction, yes. Obstufication (muddying the waters) FOR SURE.

Ie) It becomes impossible for the 'average person' to take seriously anything coming out of the mouths of people saying he's still alive...and This Is Choreographed. -

@futurebird They're all disposable to each other, all in a giant game of insecurity and status that drives them insane. None of them can sit quietly, by themselves, thinking, and just be ok, much less happy.

It's kind of the only way I can rationalize the way the treated all those young women, and teens, and "tweens" ... and little girls.

It's not a rare or bizarre kind of evil. It's the cruelty of the kind of voice says "well that's how the world works honey, life's not fair"

These people have no "friends" or "family" just useful (and useless) people.

-

It's kind of the only way I can rationalize the way the treated all those young women, and teens, and "tweens" ... and little girls.

It's not a rare or bizarre kind of evil. It's the cruelty of the kind of voice says "well that's how the world works honey, life's not fair"

These people have no "friends" or "family" just useful (and useless) people.

People with pathologies view the world as enablers and everyone else.

-

I find this shocking:

In the recent file release we have new documents that show that the prison footage of Epstein's cell was deleted by an FBI agent who was advised (or someone was advised) that this action would delete the footage.

...

OK. Sure. Great. Wonderful. Makes total sense.

This has not gotten much traction and it's making me feel a little like a crazy person.

Is anyone going to ask why the FBI deleted this footage?

@futurebird I read that they had the statement about his death written the day BEFORE he died too.

I wonder if he isn't alive.

-

I find the theory that Epstein is still alive deeply annoying and I kind of struggle to explain why?

Maybe it's because it makes *me* feel silly:I want to think that *my* skepticism is... mostly reasonable. Informed even? IDK.

But also, I just don't think it would happen. He was a very useful and connected person, but no one cared enough to go through all the work and danger of "getting him out" Why?

Even Epstein was disposable to these people.

@futurebird @zl2tod "Even Epstein was disposable to these people."

They would all happily throw each other under a bus if it benefited them.

-

@futurebird I read that they had the statement about his death written the day BEFORE he died too.

I wonder if he isn't alive.

-

It's kind of the only way I can rationalize the way the treated all those young women, and teens, and "tweens" ... and little girls.

It's not a rare or bizarre kind of evil. It's the cruelty of the kind of voice says "well that's how the world works honey, life's not fair"

These people have no "friends" or "family" just useful (and useless) people.

@futurebird it's a deeply tragic life. It's gone so wrong that they lose sight of basic human decency, and there's no one who can sit them down and get them on the straight and narrow.